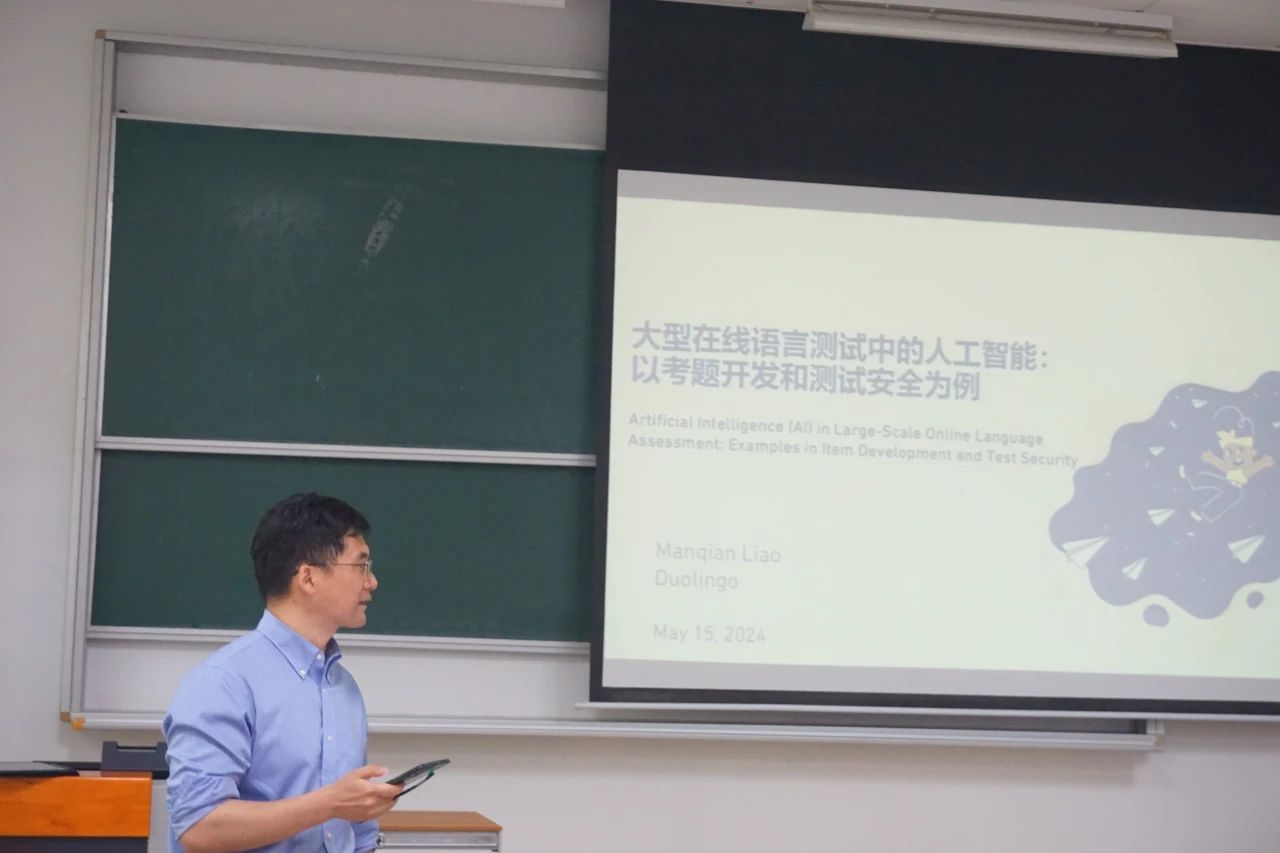

跨学科沙龙 | 大型在线语言测试中的人工智能(AI):以考题开发和测试安全为例 发布时间:2024-05-20 浏览次数:12 跨学科沙龙 大型在线语言测试中的人工智能(AI):以考题开发和测试安全为例 2024年5月15日星期三下午,华东师范大学教育心理学系圆满举行了题为“大型在线语言测试中的人工智能(AI):以考题开发和测试安全为例”的跨学科沙龙。本次活动由郑蝉金老师主持,教心系学生积极参与。

主持人|郑蝉金 主讲人|廖曼茜 讲座伊始,郑蝉金老师对参加本次活动的老师和同学们表示了热烈的欢迎,并介绍了本次讲座的主讲人廖曼茜(Mancy)博士。Mancy拥有心理学本科学位和测量及统计方向的博士学位,目前就职于多邻国(Duolingo),担任高级测量学家一职。她的工作重点是确保多邻国英语测试(特别是高风险测试)的分数公平性和准确性,致力于研究如何设计考试和评分机制,以更准确地反映考生的英语水平,并有效检测学生的作弊行为。 多邻国英语测试 Mancy首先介绍了多邻国英语测试的概念。该测试旨在利用技术为学生提供便利,允许他们不用线下前往指定考点,在家即可远程完成在线考试。考试设置了两到三名老师远程监考,并可以在48小时内提供成绩结果。与其他考试相比,多邻国英语测试在时间和费用上更具优势,这主要得益于其考试设计框架及考试过程中的自动化处理。学生可以随时随地进行考试,具有了极大的便捷性。为实现这种便捷化的功能,多邻国英语测试采用了大题库和自动评分系统。目前可以实现包括考题生成、考题评分和监考等功能在内的不同自动化程度的流程。

随后,Mancy以考题生成和监考为例,介绍了如何将AI与人工审查结合起来。 Example 1:考题生成 在传统的考题生成过程中,人工编写题目、进行试测、心理测量分析,以及根据反馈对题目进行多轮修改这一系列过程既耗时又费力。为了提高效率,多邻国使用大语言模型(如GPT)大批量生成考题。GPT由于经过大量预训练,学习过大量语料,因此能够生成所需的内容,且具有很强的模仿和改写能力,也容易实现题目的统一性。在考题生成中,GPT用于生成试题的不同部分,此外还会进行人工审查,并会结合前测和人工审查的结果进行改进。

随后,Mancy以互动阅读和互动听力这两个具体的例子讲解了GPT是如何应用于题目生成的。互动阅读要求考生先阅读一篇文章,然后完成一系列任务,这些任务会随着学生完成的进度逐步呈现,包括完形填空、选过渡句、在文章中标出正确答案、文章大意题和找出适合标题等。Mancy指出,在题目生成过程中,如何生成错误选项是最具挑战性的部分。 在题目生成过程中,多邻国首先使用GPT生成大量的文章,并且通过提供话题、主题和文章的例子来控制语言风格和格式。接下来生成不同类型的问题,同时考虑问题的通用性和开放性。对于选择题选项的生成,尤其是错误答案的生成,采取的解决方案是:利用GPT基于原始文章生成类似文章,然后提取这些类似文章的主题作为错误答案,这种方法在实践中比直接生成错误答案更为高效。 互动听力则要求考生扮演一个角色,与对方进行对话,模拟大学情境,并在对话中选择合适的回答以推进对话。考生只有一次听对话的机会,并需要在最后总结对话内容。在这类问题的生成中,需要考虑的第一个问题是如何生成适配大学情境的对话,并给基本的情境添加一些细节,使内容丰富有趣。对此,采取解决的方案是:为GPT提供一些扩展好的话题,使其加以模仿。但在这种方案中,GPT会表现出对专业有所偏好,心理学的相关话题比其他专业更多,因此需要让GPT对内容进行进一步的改写。而另一个问题与互动阅读相似,即如何生成错误选项。在这个情境下,采取解决的方法为:抽取生成的所有对话中具有共性的语句作为错误选项,也可以对抽取进一步约束以提高题目难度。

在题目开发的过程中,AI生成的题目质量参差不齐,因此人工审查是一个必不可少的步骤。这一审查过程不仅关注题目的质量,还涉及公平性的考量。为了实现这一目标,多邻国要求参与审查的专家都需要具备一定的资质。通过收集专家的审查意见、修改建议以及他们投入的时间,多邻国能够对AI模型进行更深入的分析和改进。这些数据不仅有助于改进现有的AI模型,还能基于此开发出更加精准的AI筛选模型。并且,多邻国会使用编辑距离来观察AI生成的题目质量,得出的结果表明,尽管大多数生成的内容需要一定程度的修改,但所需的编辑距离通常小于0.1,这意味着这些修改主要是细微调整,而非根本性的改变。

总结来说,题目生成部分面临的挑战在于如何大批量地生成高质量的内容。这对人工和AI来说都是一项艰巨的任务,但通过将两者的优势结合起来,可以更公平、高效地解决这一问题。大语言模型在这一过程中扮演着重要角色,它们能够快速、准确地生成内容,同时允许人工专注于AI目前还难以处理的更复杂的问题。此外,人工的反馈结果不仅可以用于评估AI的表现,还能进一步促进AI的优化和提升。 Example 2:监考 Mancy首先向大家介绍了传统的监考模式,即通常需要考生进入同一个考场,并由1-2名考官进行现场监督。但这种做法存在一些弊端。由于考官可能固定,因此存在考官受贿的风险;同时考官的注意力也有限,难以全面监督所有考生。为了克服这些问题,多邻国提出了一种新的解决方案,即通过录像记录考生的考试过程,并利用AI技术对录像进行分析,最终由考官进行评判。这种方法的优势在于为学生和考官提供了便利,允许双方远程参与,避免了同时在场的时空需求。此外,由于考生和考官之间没有直接接触,贿赂行为变得不再可能。此外,AI的快速处理能力也大大解放了人力资源,使得更多考官能够同时远程监督同一个学生。 在实际应用中,AI能够准确且迅速地检测出抄袭行为。然而,这也带来了一个新问题:是否完全依赖人工或完全依赖AI进行监考?Mancy认为两者都不是最佳选择:如果完全依赖人工,即使有足够的人力资源,也可能因为搜索方法的不同而导致判断上的偏差;而如果完全依赖AI,则可能会错误地将使用模板写作的诚实考生标记为作弊,因为模板的使用可能只是一种学习技巧,并不代表真正的作弊行为。

随后,Mancy介绍了目前多邻国对于作弊行为检测的三个步骤。首先,多邻国建立了一个尽可能包含所有抄袭来源的数据库,包括两部分:网络抓取的与题目相关的内容,以及过去考生的答案。然后,选择一种有效且可行的文本检测方法,以识别考生答案中的抄袭行为。最后,建立一个合适的用户系统,以便考官可以综合AI的检测结果进行判断。如果发现考生答案与数据库的相似度很高,将由考官进行进一步的判断。 总结 讲座最后,Mancy总结道,AI技术确实可以显著提高考试运营的效率,但人工审查在这一过程中同样不可或缺。人工审查的结果可以用来进一步提高AI的表现,确保考试的公正性和准确性。在Mancy的分享结束后,参与讲座的师生与Mancy就难度控制和判断、题目风格的生成、题目生成的指标数据与人力资源投入、以及题目生成模型的训练和使用等问题进行了深入的交流。

在本次跨学科沙龙中,教心系的师生们对多邻国英语测试的自动化和AI应用有了全面的认识。廖曼茜(Mancy)博士的分享不仅展示了AI在考题生成和监考中的创新应用,还强调了人工审查在确保考试公平性和准确性中的关键作用。 此次沙龙不仅拓展了师生们对AI在教育领域应用的认识,也激发了他们对未来教育技术发展趋势的思考和探索。相信这次沙龙的交流将激励和引导大家在教育的道路上敢于尝试、勇于创新,为实现教育的个性化适应和现代化革新贡献智慧和力量。 ~END~ |

| 联系我们 | |

| 华东师范大学教育心理学系 地址: 上海市普陀区中山北路3663号 邮政编码: 200062 联系电话: 021-62233078 电子邮件:depecnu@163.com |

|

| 版权所有 2018 华东师范大学教育心理学系 | 技术支持: 上海屹超 |